Table des matières

Article traduit librement depuis La technologie derrière l’écriture de fiction d’OpenAI, la fausse IA, explique

Comment il se traduit en PNL. Les algorithmes basés sur la sémantique distributionnelle ont été largement responsables les récentes percées en matière de PNL. Ils utilisent l’apprentissage machine pour traiter un texte, en trouvant des modèles en comptant essentiellement la fréquence et l’étroitesse des mots utilisés les uns par rapport aux autres. Les modèles qui en résultent peuvent ensuite utiliser ces modèles pour construire des phrases ou des paragraphes complets, et alimenter des choses comme l’autocomplétion ou d’autres systèmes de texte prédictif. Ces dernières années, certains chercheurs ont également commencé à étudier la distribution des séquences de caractères aléatoires plutôt que celle des mots, de sorte que les modèles peuvent traiter avec plus de souplesse les acronymes, la ponctuation, l’argot et d’autres éléments qui n’apparaissent pas dans le dictionnaire, ainsi que les langues qui n’ont pas de délimitation claire entre les mots.

Pour. Ces algorithmes sont souples et évolutifs, car ils peuvent être appliqués dans n’importe quel contexte et tirer des enseignements des données non étiquetées.

Contre. Les modèles qu’ils produisent ne comprennent pas vraiment les phrases qu’ils construisent. En fin de compte, ils écrivent de la prose en utilisant des associations de mots.

#2. Sémantique des cadres

Philosophie linguistique. Le langage est utilisé pour décrire des actions et des événements, de sorte que les phrases peuvent être subdivisées en sujets, verbes et modificateursqui, quoi, oùet quand.

Comment il se traduit en PNL. Les algorithmes basés sur la sémantique des cadres utilisent un ensemble de règles ou de nombreuses données de formation étiquetées pour apprendre à déconstruire les phrases. Ils sont donc particulièrement adaptés à l’analyse de commandes simples, et donc utiles pour les chatbots ou les assistants vocaux. Si vous demandiez à Alexa de « trouver un restaurant quatre étoiles pour demain », par exemple, un tel algorithme trouverait comment exécuter la phrase en la décomposant en action (« find »), le quoi (« restaurant quatre étoiles »), et le quand (« demain »).

Pour. Contrairement aux algorithmes distributifs-sémantiques, qui ne comprennent pas le texte dont ils tirent des enseignements, les algorithmes frame-sémantiques peuvent distinguer les différents éléments d’information dans une phrase. Ils peuvent être utilisés pour répondre à des questions telles que « Quand cet événement a-t-il lieu ?

Contre. Ces algorithmes ne peuvent traiter que des phrases très simples et ne parviennent donc pas à saisir les nuances. Comme ils nécessitent une formation spécifique au contexte, ils ne sont pas non plus très flexibles.

#3. Sémantique théorique du modèle

Philosophie linguistique. La langue est utilisée pour communiquer des connaissances humaines.

Comment il se traduit en PNL. La sémantique théorique du modèle est basée sur une vieille idée de l’IA selon laquelle toutes les connaissances humaines peuvent être encodées, ou modélisédans une série de règles logiques. Ainsi, si vous savez que les oiseaux peuvent voler, et que les aigles sont des oiseaux, vous pouvez en déduire que les aigles peuvent voler. Cette approche n’est plus en vogue car les chercheurs se sont vite rendu compte qu’il y avait trop d’exceptions à chaque règle (par exemple, les pingouins sont des oiseaux mais ne peuvent pas voler). Mais les algorithmes basés sur la sémantique théorique des modèles sont toujours utiles pour extraire des informations de modèles de connaissance, comme les bases de données. Comme les algorithmes de sémantique des cadres, ils analysent les phrases en les déconstruisant en parties. Mais alors que la sémantique des cadres définit ces parties comme les qui, quoi, oùet quandLa sémantique théorique des modèles les définit comme les règles logiques qui codent la connaissance. Prenons par exemple la question suivante : « Quelle est la plus grande ville d’Europe en termes de population ? Un algorithme de la théorie des modèles la décomposerait en une série de questions autonomes : « Quelles sont toutes les villes du monde ? » « Quelles sont celles qui se trouvent en Europe ? » « Quelle est la population des villes ? » « Quelle est la population la plus importante ? » Il serait alors en mesure de parcourir le modèle de connaissance pour vous donner votre réponse finale.

Pour. Ces algorithmes donnent aux machines la capacité de répondre à des questions complexes et nuancées.

Contre. Ils nécessitent un modèle de connaissances, dont la construction prend du temps, et ne sont pas flexibles dans différents contextes.

#4. Une sémantique fondée

Philosophie linguistique. Le langage tire son sens de l’expérience vécue. En d’autres termes, les humains ont créé le langage pour atteindre leurs objectifs, il doit donc être compris dans le contexte de notre monde axé sur les objectifs.

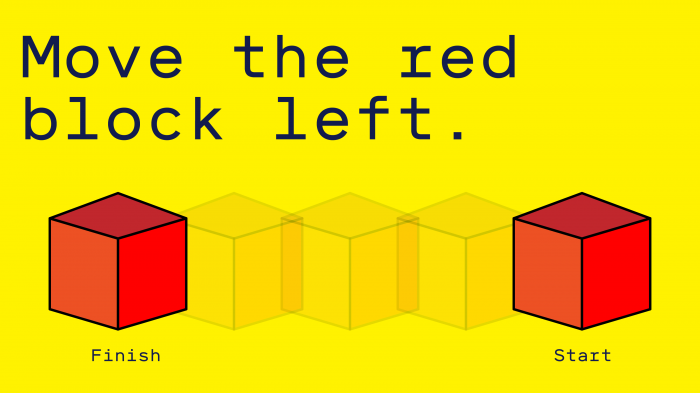

Comment il se traduit en PNL. C’est l’approche la plus récente et celle qui, selon M. Liang, est la plus prometteuse. Elle tente d’imiter la façon dont les humains apprennent le langage au cours de leur vie : la machine part d’un état vide et apprend à associer les mots aux significations correctes par la conversation et l’interaction. Dans un exemple simple, si vous vouliez apprendre à un ordinateur comment déplacer des objets dans un monde virtuel, vous lui donneriez une commande comme « Déplacez le bloc rouge vers la gauche » et lui montreriez ensuite ce que vous voulez dire. Avec le temps, la machine apprendrait à comprendre et à exécuter les commandes sans aide.

Pour. En théorie, ces algorithmes devraient être très souples et se rapprocher le plus possible d’une véritable compréhension du langage.

Contre. L’enseignement demande beaucoup de temps et tous les mots et expressions ne sont pas aussi faciles à illustrer que « Déplacez le bloc rouge ».

À court terme, pense M. Liang, le domaine de la PNL connaîtra beaucoup plus de progrès grâce à l’exploitation des techniques existantes, notamment celles basées sur la sémantique distributive. Mais à plus long terme, pense-t-il, elles ont toutes des limites. « Il y a probablement un écart qualitatif entre la façon dont les humains comprennent le langage et perçoivent le monde et nos modèles actuels », dit-il. Pour combler cet écart, il faudrait probablement adopter une nouvelle façon de penser, ajoute-t-il, et disposer de beaucoup plus de temps.

Ce document a été publié à l’origine dans notre bulletin d’information sur l’IA, The Algorithm. Pour le recevoir directement dans votre boîte de réception, s’inscrire ici gratuitement.