Table des matières

Article traduit librement depuis Mise à jour du noyau de Google de mai 2020 : Gagnants, gagnants, perdants, et pourquoi tout cela est probablement de la merde écrit par Dr-Pete

Le 4 mai, Google a annoncé qu’ils déployaient une nouvelle mise à jour du noyau. Le 7 mai, il est apparu que la poussière s’était presque entièrement dissipée. Voici une vue sur 11 jours de MozCast :

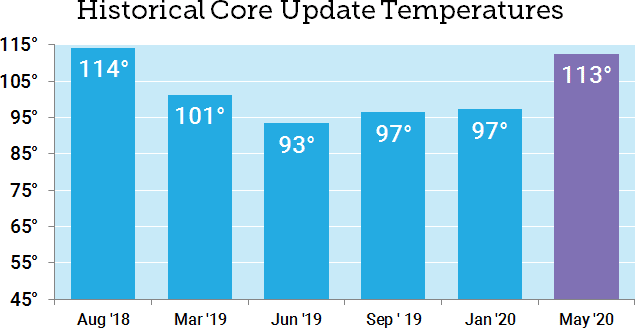

Nous avons mesuré une volatilité relativement élevée du 4 au 6 mai, avec un pic de 112,6° le 5 mai. Notez que la température moyenne sur 30 jours avant le 4 mai était historiquement très élevée (89,3°).

Comment cela se compare-t-il aux précédentes mises à jour de base ? Les températures récentes ayant été bien supérieures aux moyennes historiques, la mise à jour principale de mai 2020 a été notre deuxième mise à jour principale la plus chaude jusqu’à présent, juste en dessous de la mise à jour « Medic » d’août 2018.

Qui a « gagné » le May Core Update ?

Il est courant de signaler les gagnants et les perdants après une mise à jour importante (et je l’ai fait moi-même), mais depuis un certain temps, je crains que ces analyses ne couvrent qu’une petite fenêtre de temps. Chaque fois que nous comparons deux points fixes dans le temps, nous ignorons la volatilité naturelle des classements de recherche et les différences inhérentes entre les mots clés.

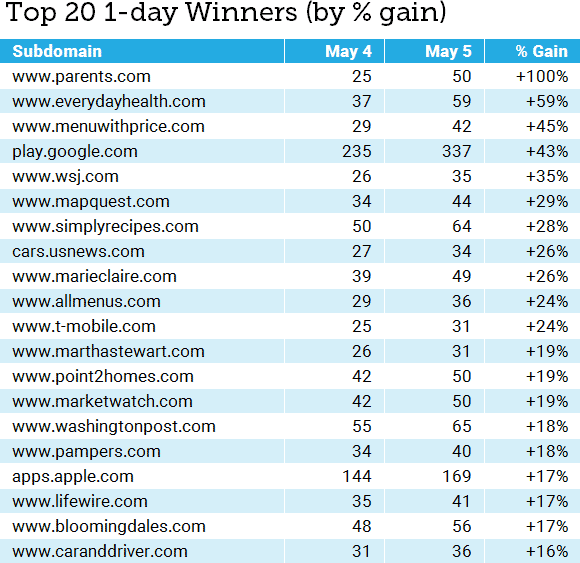

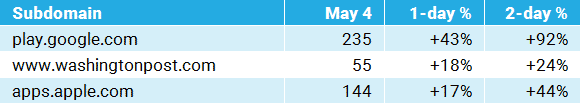

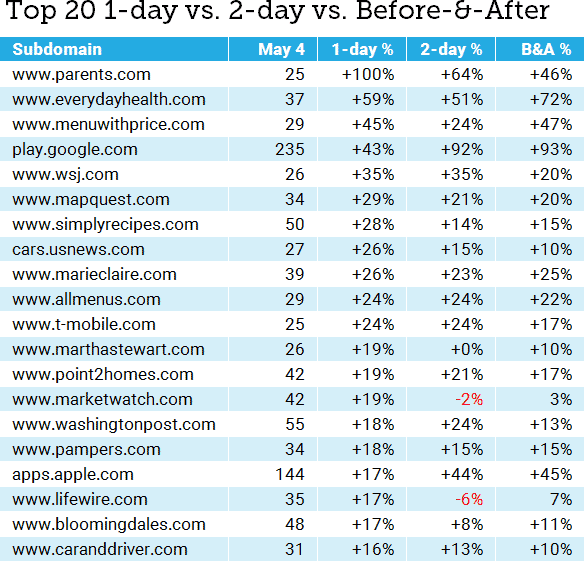

Cette fois-ci, j’aimerais examiner de près les pièges. Je vais me concentrer sur les gagnants. Le tableau ci-dessous présente les gagnants d’un jour (5 mai) par classement total dans le jeu de suivi MozCast de 10 000 mots-clés. Je n’ai inclus que les sous-domaines ayant au moins 25 classements au 4 mai :

Mis à part les suspects statistiques habituels (petites tailles d’échantillon pour certains mots clés, avantages et inconvénients uniques de notre ensemble de données, etc. ), quel est le problème de cette analyse ? Bien sûr, il y a différentes façons de rapporter le « % de gain » (comme la variation absolue par rapport au pourcentage relatif), mais j’ai rapporté les chiffres absolus honnêtement et la variation relative est exacte.

Le problème est qu’en nous précipitant pour calculer les chiffres après un jour, nous avons ignoré la réalité, à savoir que la plupart des mises à jour de base sont pluri-journalières (une tendance qui semble se poursuivre pour la mise à jour de base de mai, comme le montre notre graphique initial). Nous n’avons pas non plus tenu compte des domaines dont les classements peuvent être historiquement volatils (mais nous y reviendrons plus tard). Que se passe-t-il si nous comparons les données sur 1 jour et sur 2 jours ?

Quelle histoire racontons-nous ?

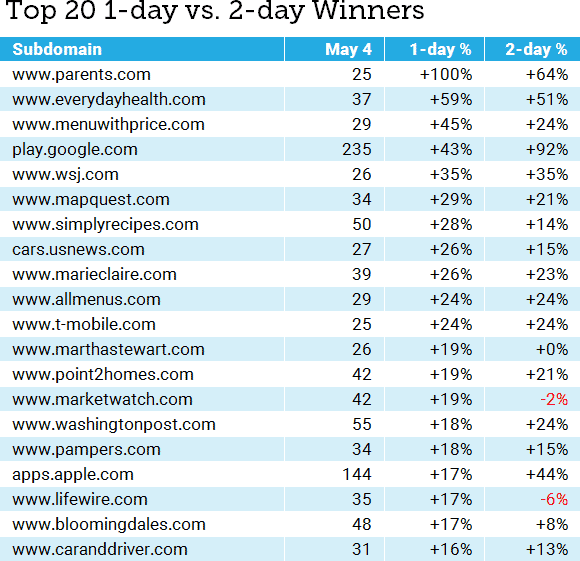

Le tableau ci-dessous ajoute le pourcentage relatif de 2 jours gagnés. J’ai conservé les 25 sous-domaines et je continuerai à les trier en fonction du pourcentage gagné en un jour, par souci de cohérence :

Même en comparant les deux premiers jours du déploiement, nous pouvons constater que l’histoire évolue considérablement. Le problème est le suivant : Quelle histoire racontons-nous ? Souvent, nous ne regardons même pas des listes, mais des anecdotes basées sur nos propres clients ou des données choisies avec soin. Considérez cette histoire :

Si c’était notre seule vue des données, nous conclurions probablement que la mise à jour s’est intensifiée au cours des deux jours, le deuxième jour récompensant encore plus les sites. Nous pourrions même commencer à rédiger un article sur l’augmentation de la demande d’applications ou sur les récompenses accordées à certains sites d’information. Ces histoires pourraient avoir un grain de vérité, mais le fait est que nous n’avons aucune idée à partir de ces seules données.

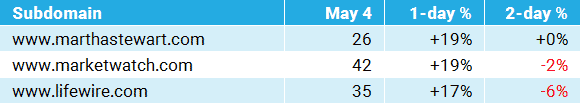

Maintenant, choisissons trois points de données différents (tous font partie des 20 premiers) :

De ce point de vue limité, on peut conclure que Google a décidé que la mise à jour du noyau dur a mal tourné et l’a inversé le deuxième jour. Nous avons même pu conclure que certains sites d’information étaient pénalisés pour une raison quelconque. Cela raconte une histoire radicalement différente de la première série d’anecdotes.

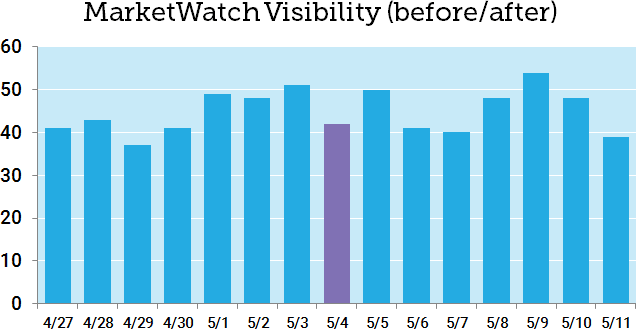

Il y a une histoire encore plus étrange enfouie dans les données de mai 2020. Considérez ceci :

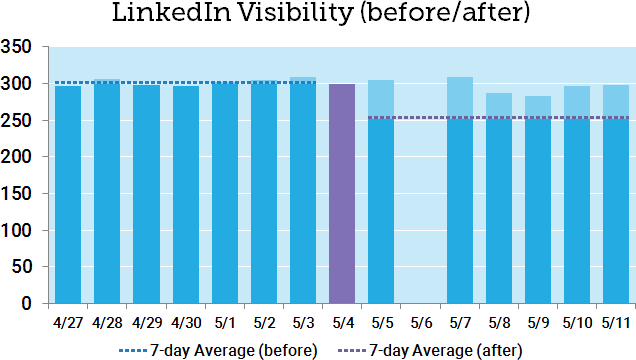

LinkedIn a montré une petite bosse (que nous ignorons généralement) le premier jour et a ensuite perdu 100% de son classement le deuxième jour. Wow, cette mise à jour de May Core a vraiment du punch ! Il s’avère que LinkedIn a peut-être accidentellement ont désindexé leur site – ils ont récupéré le lendemain, et il semble que ce changement massif n’avait rien à voir avec la mise à jour du noyau dur. La simple vérité est que ces chiffres nous en disent très peu sur les raisons pour lesquelles un site a gagné ou perdu des classements.

Comment définir le terme « normal » ?

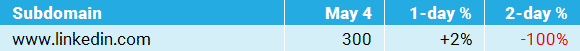

Examinons de plus près les données de MarketWatch. Marketwatch a gagné 19% dans les statistiques sur 1 jour, mais a perdu 2% dans les chiffres sur 2 jours. Le problème ici est que nous ne savons pas, à partir de ces chiffres, à quoi ressemble le flux normal du SERP de MarketWatch. Voici un graphique de sept jours avant et après le 4 mai (le début de la mise à jour de base) :

En examinant ne serait-ce qu’une petite partie des données historiques, nous pouvons constater que MarketWatch, comme la plupart des sites d’information, connaît une grande volatilité. Les « gains » du 5 mai sont uniquement dus aux pertes du 4 mai. Il s’avère que la moyenne sur 7 jours après le 4 mai (45,7) n’est qu’une légère augmentation par rapport à la moyenne sur 7 jours avant le 4 mai (44,3), MarketWatch mesurant un modeste gain relatif de +3,2%.

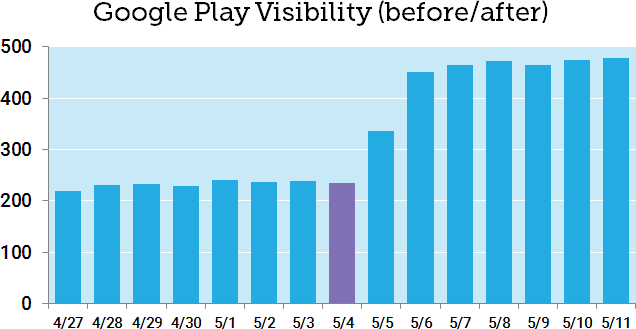

Examinons maintenant Google Play, qui semblait être clairement gagnant au bout de deux jours :

Il n’est même pas nécessaire de faire des calculs pour voir la différence. En comparant la moyenne sur 7 jours avant le 4 mai (232,9) à la moyenne sur 7 jours après (448,7), Google Play a connu un changement relatif spectaculaire de +93 % après la mise à jour de base de mai.

Comment fonctionne cette comparaison avant/après 7 jours avec l’incident LinkedIn ? Voici un graphique avant/après avec les pointillés ajoutés pour les deux moyens :

Bien que cette approche contribue certainement à compenser l’anomalie d’un seul jour, nous affichons toujours un changement avant/après de -16%, ce qui n’est pas vraiment conforme à la réalité. Vous pouvez voir que six des sept jours après la mise à jour de base de mai étaient au-dessus de la moyenne de sept jours. Notez que LinkedIn a également une volatilité relativement faible sur l’historique à court terme.

Pourquoi est-ce que je choisis un exemple extrême où mon nouveau système métrique est insuffisant ? Je veux qu’il soit parfaitement clair qu’aucune mesure ne peut jamais tout dire. Même si nous tenions compte de la variance et faisions des tests statistiques, il nous manque encore beaucoup d’informations. Une différence avant/après claire ne nous dit pas ce qui s’est réellement passé, mais seulement qu’il y a eu un changement en corrélation avec le moment de la mise à jour de base. Ce sont des informations utiles, mais elles doivent encore être étudiées avant que nous ne tirions des conclusions générales.

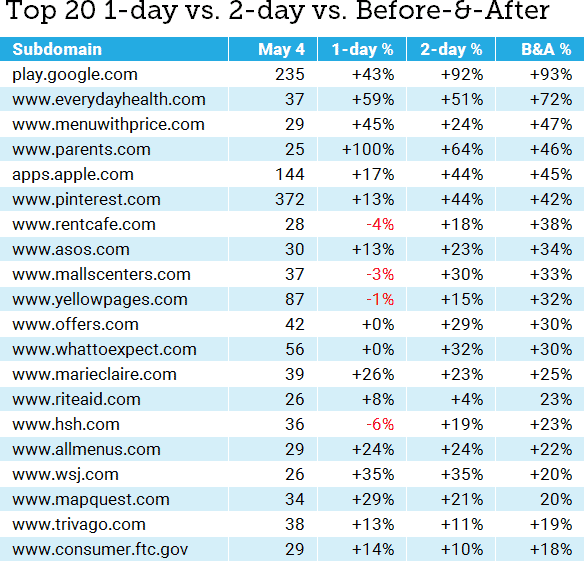

Dans l’ensemble, cependant, l’approche est certainement meilleure que les tranches d’un jour. L’utilisation de la comparaison de la moyenne sur 7 jours avant et après tient compte à la fois des données historiques et des 7 jours complets après la mise à jour. Et si nous étendions cette comparaison des périodes de 7 jours à l’ensemble des données plus importantes ? Voici notre liste originale des « gagnants » avec les nouveaux chiffres :

Il est évident que cela fait beaucoup à digérer dans un seul tableau, mais nous pouvons commencer à voir où la mesure avant/après (la différence relative entre les moyennes de 7 jours) donne une image différente, dans certains cas, de celle de 1 ou 2 jours. Reconstruisons les 20 premiers en nous basant sur le pourcentage de variation avant et après :

Certains des grands acteurs sont les mêmes, mais nous avons aussi quelques nouveaux venus – y compris des sites qui semblaient avoir perdu leur visibilité le premier jour, mais qui ont accumulé des gains sur deux et sept jours.

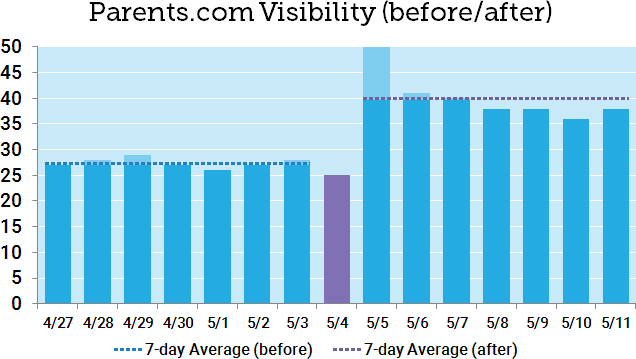

Jetons un rapide coup d’œil sur Parents.com, notre grand gagnant original (gagnant ? gagnant ?). Le premier jour, le gain a été énorme (+100 %), mais les chiffres du deuxième jour ont été plus modestes, et les gains avant et après se sont élevés à un peu moins de la moitié du gain du premier jour. Voici les sept jours avant et après :

Il est facile de voir ici que le saut du premier jour était une anomalie à court terme, basée en partie sur une baisse le 4 mai. La comparaison des moyennes sur sept jours semble se rapprocher de la vérité. C’est un avertissement non seulement pour les traqueurs d’algo comme moi, mais aussi pour les SEO qui pourraient voir ce +100% et se précipiter pour le dire à leur patron ou client. Ne laissez pas une bonne nouvelle se transformer en une promesse que vous ne pouvez pas tenir.

Pourquoi continuons-nous à faire cela ?

Si vous avez l’impression que je fais appel à l’industrie, notez que je suis dans ma ligne de mire. La pression est énorme pour que les analyses soient publiées rapidement, non seulement parce que cela équivaut à du trafic et des liens (franchement, c’est le cas), mais aussi parce que les propriétaires de sites et les référenceurs veulent vraiment des réponses. Comme je l’ai écrit récemment, je pense qu’il est extrêmement dangereux de surinterpréter les pertes à court terme et les réparer les mauvaises choses. Cependant, je pense qu’il y a aussi un réel danger à exagérer les gains à court terme et à s’attendre à ce que ces gains soient permanents. Cela peut conduire à des décisions tout aussi risquées.

Est-ce que tout cela est de la merde ? Non, je ne pense pas, mais je pense qu’il est très facile de quitter le trottoir et de se retrouver dans la boue après une tempête, et qu’il faut au moins attendre que le sol soit sec. Ce n’est pas facile dans un monde de Twitter et de cycles d’information de 24 heures, mais il est essentiel d’avoir une vue sur plusieurs jours, d’autant plus que de nombreuses mises à jour d’algorithmes importants se déroulent sur de longues périodes.

Quels chiffres faut-il croire ? En un sens, tous, ou du moins tous ceux que nous pouvons vérifier de manière adéquate. Aucune mesure ne peut à elle seule brosser un tableau complet, et avant de vous précipiter pour célébrer votre victoire, il est important de passer à l’étape suivante et de bien comprendre les tendances historiques et le contexte de toute victoire.

Qui veut des données gratuites ?

Étant donné la portée de l’analyse, je n’ai pas couvert les perdants du Core Update de mai 2020 dans ce post ni dépassé le Top 20, mais vous pouvez télécharger les données brutes ici. Si vous souhaitez l’éditer, veuillez d’abord en faire une copie. Les gagnants et les perdants se trouvent sur des onglets séparés, et cela couvre tous les domaines avec au moins 25 classements dans notre ensemble de données MozCast 10K le 4 mai (un peu plus de 400 domaines).