Table des matières

Article traduit librement depuis Fichier Robots.txt [2020 Examples] – Moz

Qu’est-ce qu’un fichier robots.txt ?

Robots.txt est un fichier texte que les webmasters créent pour apprendre aux robots du web (généralement des robots de moteurs de recherche) comment explorer les pages de leur site web. Le fichier robots.txt fait partie du protocole d’exclusion des robots (REP), un groupe de normes web qui régit la manière dont les robots explorent le web, accèdent et indexent le contenu, et le servent aux utilisateurs. Le REP comprend également des directives telles que les méta-robotsainsi que des instructions pour la page, le sous-répertoire ou le site dans son ensemble sur la manière dont les moteurs de recherche doivent traiter les liens (comme « follow » ou « nofollow »).

En pratique, Les fichiers robots.txt indiquent si certains agents utilisateurs (logiciels d’exploration du web) peuvent ou non explorer des parties d’un site web. Ces instructions d’exploration sont spécifiées en « interdisant » ou en « autorisant » le comportement de certains (ou de tous) les agents utilisateurs.

Format de base :

User-agent: [user-agent name]Disallow: [URL string not to be crawled]

Ensemble, ces deux lignes sont considérées comme une fichier robots.txt complet – bien qu’un fichier de robots puisse contenir plusieurs lignes d’agents et de directives d’utilisateur (c’est-à-dire, interdit, autorise, délai d’attente, etc.).

Dans un fichier robots.txt, chaque ensemble de directives utilisateur-agent apparaît comme un ensemble discretséparés par un saut de ligne :

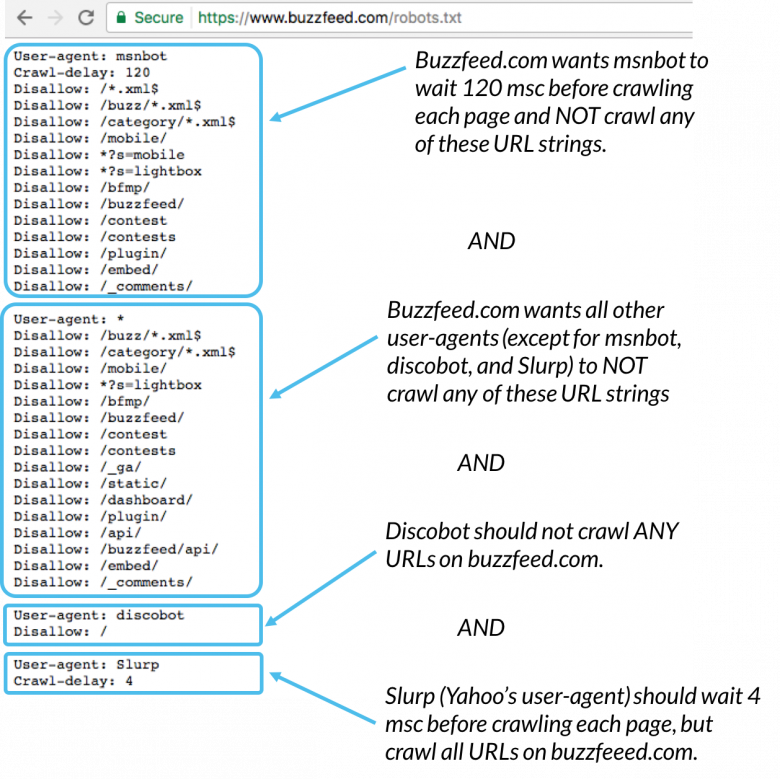

Dans un fichier robots.txt contenant plusieurs directives d’agent utilisateur, chacune d’entre elles interdit ou autorise une règle uniquement s’applique au(x) agent(s) utilisateur(s) spécifié(s) dans cet ensemble particulier de lignes séparées. Si le fichier contient une règle qui s’applique à plus d’un user-agentun chenille uniquement faire attention à (et suivre les directives en) les plus spécifiques groupe d’instructions.

Voici un exemple :

Msnbot, discobot et Slurp sont tous appelés spécifiquement, de sorte que ces agents-utilisateurs uniquement faites attention aux directives dans leurs sections du fichier robots.txt. Tous les autres user-agents suivront les directives de l’user-agent : groupe *.

Exemple robots.txt :

Voici quelques exemples de robots.txt en action pour un www.example.com site :

URL du fichier Robots.txt : www.example.com/robots.txt

Bloquer tous les crawlers du web de tout contenu

User-agent: * Disallow: /

L’utilisation de cette syntaxe dans un fichier robots.txt indiquerait à tous les robots d’exploration du web de ne pas explorer les pages sur www.example.comy compris la page d’accueil.

Permettre à tous les crawlers d’accéder à l’ensemble du contenu

User-agent: * Disallow:

L’utilisation de cette syntaxe dans un fichier robots.txt indique aux crawlers d’explorer toutes les pages du site www.example.comy compris la page d’accueil.

Bloquer un crawler spécifique d’un dossier spécifique

User-agent: Googlebot Disallow: /example-subfolder/

Cette syntaxe indique uniquement au crawler de Google (nom d’agent utilisateur Googlebot) de ne pas explorer les pages qui contiennent la chaîne d’URL www.example.com/example-subfolder/.

Blocage d’un crawler spécifique d’une page web spécifique

User-agent: Bingbot Disallow: /example-subfolder/blocked-page.html

Cette syntaxe indique uniquement le crawler de Bing (nom d’agent utilisateur Bing) pour éviter de crawler la page spécifique à www.example.com/example-subfolder/blocked-page.html.

Comment fonctionne robots.txt ?

Les moteurs de recherche ont deux emplois principaux :

- Ramper sur le web pour découvrir du contenu ;

- L’indexation de ce contenu afin qu’il puisse être servi aux chercheurs qui recherchent des informations.

Pour parcourir les sites, les moteurs de recherche suivent des liens pour se rendre d’un site à l’autre – en fin de compte, ils parcourent plusieurs milliards de liens et de sites web. Ce comportement de crawling est parfois appelé « spidering ».

Après être arrivé sur un site web mais avant de le parcourir, le robot de recherche cherchera un fichier robots.txt. S’il en trouve un, le robot d’indexation lira d’abord ce fichier avant de poursuivre la page. Parce que le fichier robots.txt contient des informations sur comment le moteur de recherche devrait fonctionner en mode crawl, les informations trouvées sur ce site donneront des instructions pour d’autres actions de crawl sur ce site particulier. Si le fichier robots.txt fait pas contiennent des directives qui interdisent l’activité d’un user-agent (ou si le site n’a pas de fichier robots.txt), il procédera à l’exploration d’autres informations sur le site.

Autres robots rapides.txt à connaître :

(voir ci-dessous pour plus de détails)

-

Pour être trouvé, un fichier robots.txt doit être placé dans le répertoire de premier niveau d’un site web.

-

Robots.txt est sensible à la casse : le fichier doit être nommé « robots.txt » (pas Robots.txt, robots.TXT, ou autre).

-

Certains agents utilisateurs (robots) peuvent choisir d’ignorer votre fichier robots.txt. C’est particulièrement fréquent avec les crawlers plus malveillants comme les robots malveillants ou les gratteurs d’adresses électroniques.

-

Le fichier /robots.txt est un fichier accessible au public : il suffit d’ajouter /robots.txt à la fin de n’importe quel domaine racine pour voir les directives de ce site (si ce site a un fichier robots.txt !). Cela signifie que tout le monde peut voir les pages que vous faites ou ne voulez pas faire explorer, alors ne les utilisez pas pour cacher des informations privées sur l’utilisateur.

-

Chaque sous-domaine d’un domaine racine utilise des fichiers robots.txt séparés. Cela signifie que blog.example.com et example.com doivent tous deux avoir leurs propres fichiers robots.txt (à l’adresse blog.example.com/robots.txt et example.com/robots.txt).

-

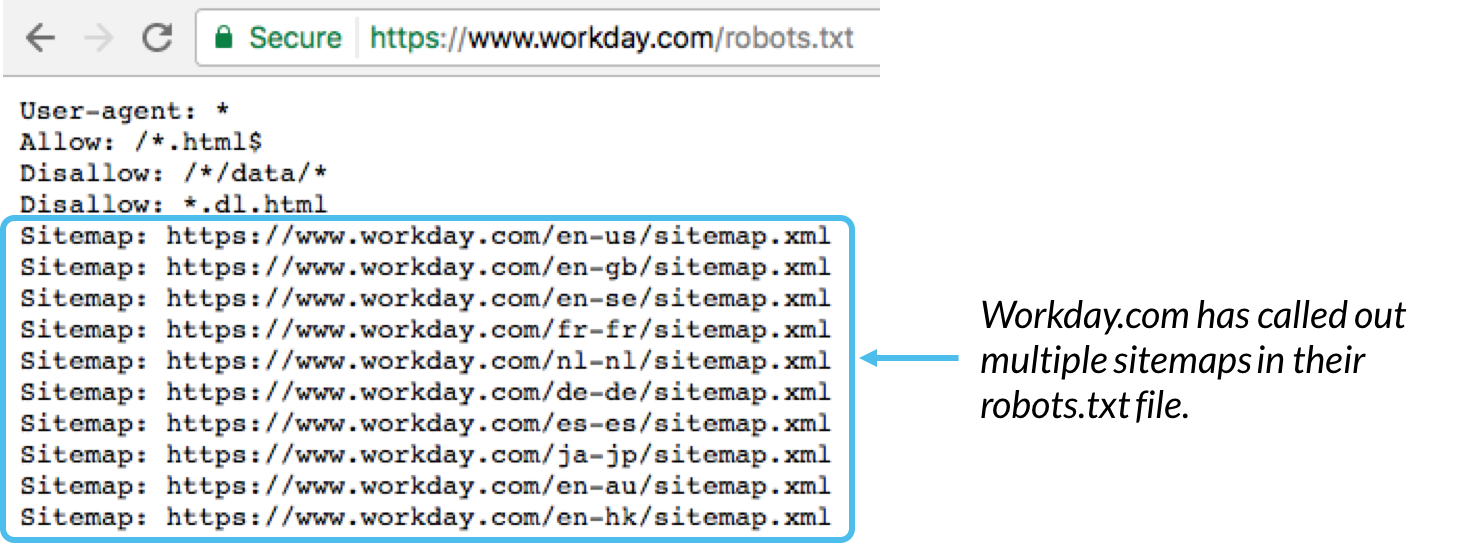

Il est généralement préférable d’indiquer l’emplacement de tout plans du site associé à ce domaine au bas du fichier robots.txt. Voici un exemple :

Syntaxe de technical robots.txt

La syntaxe de Robots.txt peut être considérée comme le « langage » des fichiers robots.txt. Il existe cinq termes courants que vous rencontrerez probablement dans un fichier robots. Il s’agit de :

-

User-agent : Le crawler spécifique auquel vous donnez des instructions de crawl (généralement un moteur de recherche). Une liste de la plupart des agents utilisateurs peut être trouvée ici.

-

Rejeter : La commande utilisée pour dire à un user-agent de ne pas explorer une URL particulière. Une seule ligne « Disallow : » est autorisée pour chaque URL.

-

Autoriser (Uniquement applicable pour Googlebot) : La commande permettant d’indiquer à Googlebot qu’il peut accéder à une page ou à un sous-dossier même si sa page ou son sous-dossier parent peut être interdit.

-

Ramper-retarder : Combien de secondes un crawler doit-il attendre avant de charger et d’explorer le contenu d’une page. Notez que Googlebot n’accuse pas réception de cette commande, mais Le taux d’exploration peut être défini dans la console de recherche Google.

-

Plan du site : Utilisé pour indiquer l’emplacement de tout plan de site XML associé à cette URL. Notez cette commande n’est soutenu que par Google, Ask, Bing et Yahoo.

Comparaison de modèles

En ce qui concerne les URL réelles à bloquer ou à autoriser, les fichiers robots.txt peuvent devenir assez complexes car ils permettent d’utiliser la correspondance de modèles pour couvrir une série d’options URL possibles. Google et Bing font tous deux honneur à deux expressions régulières qui peut être utilisé pour identifier les pages ou sous-dossiers qu’un SEO souhaite exclure. Ces deux caractères sont l’astérisque (*) et le signe du dollar ($).

- * est un joker qui représente toute séquence de caractères

- $ correspond à la fin de l’URL

Google propose une liste exhaustive de syntaxes et d’exemples de correspondance de modèles possibles ici.

Où va robots.txt sur un site ?

Chaque fois qu’ils arrivent sur un site, les moteurs de recherche et autres robots qui parcourent le web (comme Le crawler de FacebookFacebot) savent qu’il faut chercher un fichier robots.txt. Mais, ils ne chercheront ce fichier que dans un lieu spécifique : le répertoire principal (généralement votre domaine racine ou votre page d’accueil). Si un agent utilisateur visite www.example.com/robots.txt et ne y trouver un fichier de robots, il supposera que le site n’en a pas et procédera à l’exploration de tout ce qui se trouve sur la page (et peut-être même sur l’ensemble du site). Même si la page robots.txt a fait existent, par exemple, sur example.com/index/robots.txt ou www.example.com/homepage/robots.txt, il ne serait pas découvert par les agents utilisateurs et le site serait donc traité comme s’il n’avait pas de fichier robots du tout.

Afin de s’assurer que votre fichier robots.txt est bien trouvé, l’inclure toujours dans votre répertoire principal ou votre domaine racine.

Pourquoi avez-vous besoin de robots.txt ?

Les fichiers robots.txt contrôlent l’accès des robots d’indexation à certaines zones de votre site. Bien que cela puisse être très dangereux si vous interdisez accidentellement à Googlebot de fouiller tout votre site ( !!), il existe certaines situations dans lesquelles un fichier robots.txt peut être très pratique.

Voici quelques cas d’utilisation courante :

- Empêcher les contenus dupliqués d’apparaître dans les SERP (à noter que les méta-robots sont souvent un meilleur choix pour cela)

- Garder des sections entières d’un site web privées (par exemple, le site de votre équipe d’ingénieurs)

- Empêcher les pages de résultats de recherche internes d’apparaître sur un SERP public

- Préciser l’emplacement du (des) plan(s) de site

- Empêcher les moteurs de recherche d’indexer certains fichiers sur votre site web (images, PDF, etc.)

- Spécifier un délai d’exploration afin d’éviter que vos serveurs ne soient surchargés lorsque les robots d’exploration chargent plusieurs éléments de contenu en même temps

S’il n’y a pas de zones de votre site auxquelles vous souhaitez contrôler l’accès des agents utilisateurs, vous n’avez peut-être pas du tout besoin d’un fichier robots.txt.

Vérifier si vous avez un fichier robots.txt

Vous ne savez pas si vous avez un fichier robots.txt ? Saisissez simplement votre domaine racine, puis ajoutez /robots.txt à la fin de l’URL. Par exemple, le fichier robots.txt de Moz se trouve à l’adresse moz.com/robots.txt.

Si aucune page .txt n’apparaît, c’est que vous n’avez pas de page robots.txt (en direct) pour le moment.

Comment créer un fichier robots.txt

Si vous avez constaté que vous n’aviez pas de fichier robots.txt ou si vous souhaitez modifier le vôtre, en créer un est un processus simple. Cet article à partir de Google, se promène dans le processus de création du fichier robots.txt, et cet outil vous permet de vérifier si votre dossier est correctement constitué.

Vous cherchez à vous entraîner à créer des fichiers robots ? Cet article de blog se promène à travers quelques exemples interactifs.

Les meilleures pratiques en matière d’OSE

-

Assurez-vous que vous ne bloquez aucun contenu ou section de votre site web que vous souhaitez explorer.

-

Les liens sur des pages bloquées par robots.txt ne seront pas suivis. Cela signifie que 1) à moins qu’elles ne soient également liées à d’autres pages accessibles par les moteurs de recherche (c’est-à-dire des pages non bloquées par robots.txt, méta-robots ou autres), les ressources liées ne seront pas explorées et ne pourront pas être indexées. 2.) Non lien équité peut être passé de la page bloquée à la destination du lien. Si vous avez des pages vers lesquelles vous souhaitez que l’équité soit transmise, utilisez un mécanisme de blocage différent de celui de robots.txt.

-

N’utilisez pas robots.txt pour empêcher des données sensibles (comme des informations privées sur l’utilisateur) d’apparaître dans les résultats du SERP. Étant donné que d’autres pages peuvent renvoyer directement à la page contenant des informations privées (contournant ainsi les directives robots.txt de votre domaine racine ou de votre page d’accueil), celle-ci peut quand même être indexée. Si vous souhaitez bloquer votre page dans les résultats de recherche, utilisez un méthode différente comme la protection par mot de passe ou le noindex meta directive.

-

Certains moteurs de recherche ont plusieurs agents utilisateurs. Par exemple, Google utilise Googlebot pour la recherche organique et Googlebot-Image pour la recherche d’images. La plupart des agents utilisateurs d’un même moteur de recherche suivent les mêmes règles. Il n’est donc pas nécessaire de spécifier des directives pour chacun des multiples crawlers d’un moteur de recherche, mais le fait de pouvoir le faire vous permet d’affiner la façon dont le contenu de votre site est crawlé.

-

Un moteur de recherche met en cache le contenu de robots.txt, mais il met généralement à jour le contenu mis en cache au moins une fois par jour. Si vous modifiez le fichier et souhaitez le mettre à jour plus rapidement que ce qui se passe, vous pouvez soumettre votre url robots.txt à Google.

Robots.txt vs méta-robots vs x-robots

Tant de robots ! Quelle est la différence entre ces trois types d’instructions pour les robots ? Tout d’abord, robots.txt est un véritable fichier texte, alors que les méta-bots et les x-robots sont des méta-directives. Au-delà de ce qu’ils sont réellement, les trois remplissent des fonctions différentes. Robots.txt dicte le comportement d’exploration du site ou de l’annuaire, tandis que les méta-robots et les x-robots peuvent dicter le comportement d’indexation au niveau de la page individuelle (ou de l’élément de page).

Continuer à apprendre

Mettez vos compétences à profit

Moz Pro peut déterminer si votre fichier robots.txt bloque notre accès à votre site web. Essayez-le >>

![Fichier Robots.txt [2020 Examples] - Moz](https://www.seodecollageimmediat.com/assets/moz-stairs-homepage-banner-v2.jpg)